Samsung và SK hynix được cho là sẽ tăng giá bộ nhớ lên tới 30%

Siêu chu kỳ bộ nhớ do AI thúc đẩy dường như đang trở nên không thể ngăn cản, và các “ông lớn” trong ngành đã bắt đầu phản ứng bằng cách tăng giá. Theo tờ Korean Economic Daily, Samsung và SK hynix đã nâng giá DRAM và NAND flash lên tới 30% trong quý IV, đồng thời chuyển mức giá mới này cho khách hàng.

Đáng chú ý, các nhà phân tích được trích dẫn trong báo cáo dự báo rằng siêu chu kỳ bộ nhớ hiện nay sẽ kéo dài hơn và mạnh mẽ hơn so với các giai đoạn bùng nổ trước đây. Korean Economic Daily cho biết tình trạng thiếu hụt nguồn cung có thể kéo dài từ ba đến bốn năm, do tác động của nhiều yếu tố cộng hưởng: đầu tư khổng lồ vào hệ thống máy chủ AI trị giá hàng trăm nghìn tỷ won, nhu cầu nâng cấp bộ nhớ cho máy chủ đa năng, và xu hướng mở rộng AI trên các thiết bị người dùng.

Theo Chosun Daily, trước nguy cơ thiếu hụt DRAM, nhiều tập đoàn công nghệ và nhà khai thác trung tâm dữ liệu lớn tại Mỹ và Trung Quốc đang chủ động tích trữ hàng, đồng thời đàm phán các hợp đồng cung ứng trung và dài hạn (từ 2–3 năm) với Samsung và SK hynix. Thông thường, các hợp đồng DRAM được ký theo quý hoặc theo năm để duy trì tính linh hoạt trong quản lý hàng tồn kho. Tuy nhiên, do dự báo nguồn cung vẫn sẽ tiếp tục khan hiếm, ngày càng nhiều công ty đang tìm cách đảm bảo nguồn cung ổn định từ sớm.

(1).jpg)

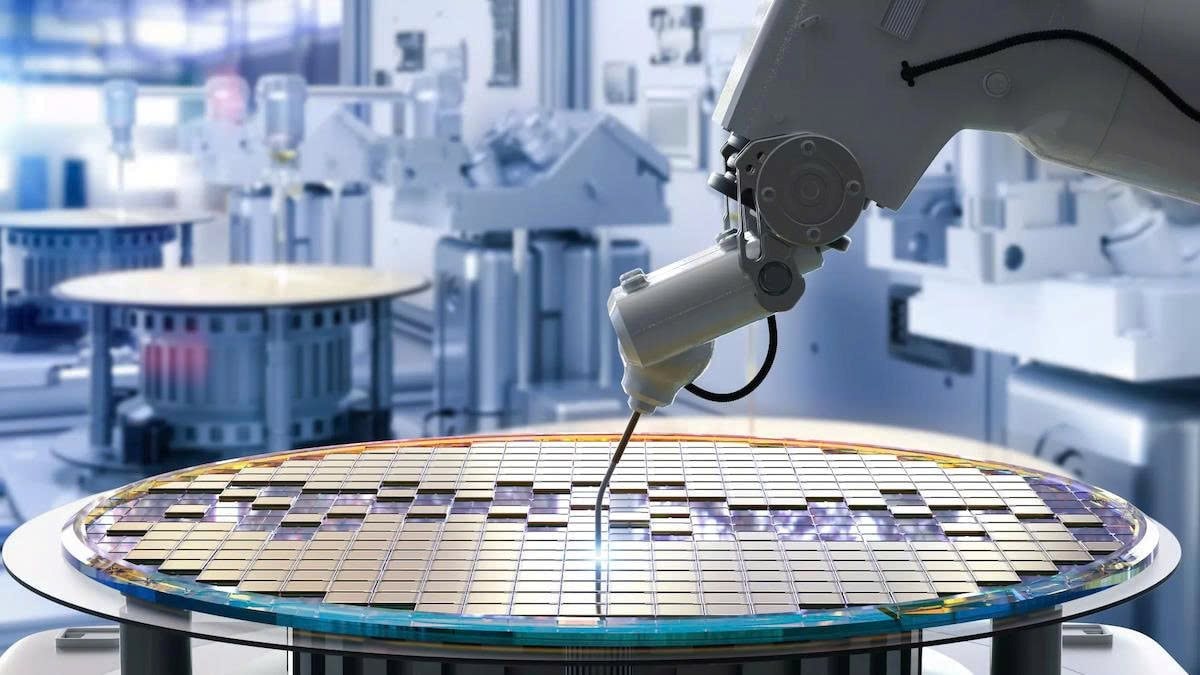

Nguồn cung DRAM thắt chặt do nhu cầu HBM tăng vọt

Giá DRAM tăng một phần do nguồn cung bị thu hẹp, chủ yếu bởi nhu cầu HBM tăng mạnh. HBM tiêu tốn gấp ba lần công suất wafer so với DRAM thông thường, theo nhận định của ông Sumit Sadhana – Giám đốc kinh doanh (CBO) của Micron, được Korean Economic Daily trích dẫn.

Việc các nhà sản xuất ưu tiên HBM là điều dễ hiểu, bởi lợi nhuận từ dòng sản phẩm này cao hơn đáng kể. Theo Korean Economic Daily, chip HBM4 12 lớp dự kiến ra mắt vào năm tới có giá khoảng 500 USD (tương đương 700.000 won), cao hơn khoảng 60% so với HBM3e 12 lớp hiện có giá khoảng 300 USD.

Tuy nhiên, báo cáo cũng nhấn mạnh rằng khi hoạt động đầu tư AI chuyển hướng từ giai đoạn huấn luyện dữ liệu khối lượng lớn sang suy luận, nhu cầu đối với cả HBM lẫn DRAM phổ thông đều tăng. DRAM vẫn giữ vai trò quan trọng nhờ khả năng xử lý dữ liệu nhanh và tiêu thụ điện năng thấp hơn so với HBM.

Chia sẻ bài viết

Bình luận

( 0 bình luận )Bình luận của bạn

Tin tức liên quan